Die Erstellung nützlicher KI-Anwendungen

Um nützliche KI-Anwendungen zu erstellen, müssen man verstehen, wie künstliche Intelligenz funktioniert und wie sie am besten eingesetzt werden kann.

In diesem Artikel erklären wir KI und geben Einblicke in die Erstellung benutzerdefinierter Anwendungen. Wir werden zeigen, was mit KI out-of-the-box möglich ist, wo die Grenzen liegen und wie diese überwunden werden können.

Das Ziel is, dass Sie Anregungen bekommen, wie KI-Anwendungen in Ihrer Arbeit eingesetzt werden können.

Zur Inspiration zeigen wir am Ende dieses Artikels einige spannende Beispiele, wie wir LLMs in verschiedene Anwendungen integriert haben.

Was ist eigentlich eine KI?

KI steht für Künstliche Intelligenz und bezeichnet die Simulation menschlicher Intelligenzprozesse durch Maschinen, bzw. Computersysteme. Wenn wir von KI sprechen, sprechen wir normalerweise von GPT-Anwendungen.

GPT steht für Generative Pretrained Transformers und bezieht sich auf einen Anwendungstyp, der eine Transformatorarchitektur nutzt. Hierbei handelt es sich um eine Deep-Learning-Modellarchitektur, die hauptsächlich für Aufgaben der Verarbeitung natürlicher Sprache verwendet wird.

Wie funktionieren sogenannte Large Language Models?

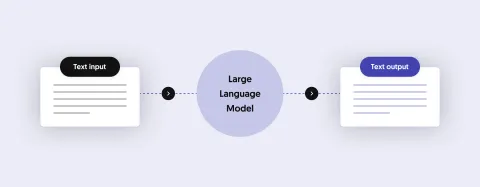

GPT-Modelle werden mit großen Textdatenmengen trainiert und sind in der Lage, basierend auf den empfangenen Eingaben sinnvollen und verständlichen Text zu generieren. Aufgrund der großen Datenmenge, auf der diese Modelle trainiert werden, werden sie auch als Large Language Models, abgekürzt LLMs oder auf Deutsch als Große Sprachmodellen bezeichnet.

Der Begriff „pretrained“ im Akronym GPT bezieht sich auf die Tatsache, dass diese Modelle zunächst anhand einer großen Menge an Textdaten mithilfe unüberwachter Lerntechniken trainiert werden. Während dieser Vortrainingsphase lernt das Modell, das nächste Wort in einer Textsequenz anhand des vorherigen Kontexts vorherzusagen. Dadurch kann das Modell ein breites Spektrum an Sprachmustern und Semantiken erfassen.

Der Begriff „generative“ im Akronym GPT bedeutet, dass diese Modelle kohärenten und kontextrelevanten Text basierend auf einer ihnen bereitgestellten Eingabeaufforderung oder Eingabe generieren können. Dies erreichen sie, indem sie das im Vortraining erlernte Wissen nutzen, um das wahrscheinlichste nächste Wort oder die nächste Wortfolge angesichts des Eingabekontexts vorherzusagen.

Wenn Sie eine KI-Anwendung erstellen möchten, stellen Sie sich das LLM als eine Software vor, die „sprechen“ kann. Das heißt, sie kann grammatikalisch korrekte Sätze erstellen, die mit hoher Wahrscheinlichkeit einen Sinn ergeben.

Natürlich kann ein solches Modell nur über das sprechen, was es „weiß“, also über Inhalte sprechen, mit denen es trainiert wurde.

Wie trainiert man LLMs? Ist es sinnvoll das selbst zu machen?

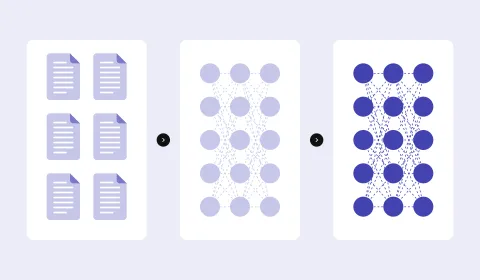

Das Trainieren eines großen Sprachmodells kann eine herausfordernde und ressourcenintensive Aufgabe sein. Es erfordert erhebliche Rechenressourcen, einschließlich leistungsstarker GPUs und einer verteilten Trainingsinfrastruktur. Das Trainieren von Modellen mit Millionen oder Milliarden Parametern ist teuer und zeitaufwändig.

Außerdem werden große Mengen hochwertiger Textdaten aus verschiedenen Quellen benötigt, und das Sammeln und Vorverarbeiten solcher Datensätze erfordert in der Regel einen erheblichen Aufwand, um die Datenqualität und -vielfalt sicherzustellen.

Wenn jedoch ausreichend Infrastruktur, Ressourcen, Zeit und Daten verfügbar sind, erfolgt die Schulung in der Regel mit einer Kombination aus unüberwachten und überwachten Lerntechniken. Dadurch werden die intrinsischen semantischen und logischen Beziehungen zwischen den Elementen in einem Datensatz entdeckt und bei der Generierung von Antworten auf Dateneingaben verwendet.

Es stehen jedoch zahlreiche vorab trainierte Allzweckmodelle zur Verfügung, die anstelle des Trainings Ihres eigenen Modells verwendet werden können. Die bekanntesten stammen von OpenAI and Mistral AI.

Normalerweise ist es viel effizienter, ein vorab trainiertes Modell in einer Anwendung einzusetzen, als ein Modell mit eigenen Daten zu trainieren.

Wie werden LLMs am besten eingesetzt?

LLMs können nur über Themen (Daten) „sprechen“, mit denen sie trainiert wurden.

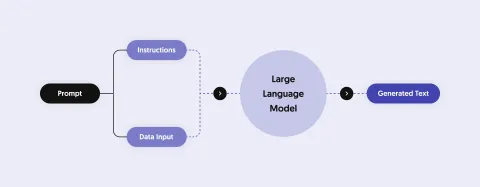

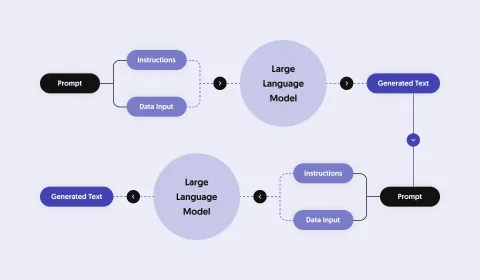

Um Fragen zu anderen Themen beantworten zu können, müssen diese Daten vor dem Stellen der Frage an das Modell übergeben werden. Dieser Vorgang wird als „In-Context-Learning“ bezeichnet.

Damit Ihre KI über ein bestimmtes Thema sprechen kann, müssen Sie die relevanten Informationen an das Sprachmodell weitergeben, bevor Sie mit ihm interagieren.

Neben der Übergabe von Daten an ein LLM übergeben Sie normalerweise zusätzliche Anweisungen, die beschreiben, wie das Modell reagieren soll.

Beispiele für solche Anweisungen sind die Tonalität, die Sie verwenden möchten, oder die Einschränkung der Themen, auf die Ihre Anwendung reagieren soll.

Wie viele Daten kann ein LLM verarbeiten?

Theoretisch können große Sprachmodelle unbegrenzt Daten verarbeiten. Die übergebenen Daten werden als Tokens bezeichnet.

Es gibt Modelle, die mit einer sehr großen Anzahl von Token umgehen können. Je mehr Daten jedoch an das Modell übergeben werden, desto komplexer wird die Berechnung sinnvoller Antworten.

Daher reagieren Modelle, die komplexere Daten verstehen, langsamer und sind im Vergleich zu kleineren Modellen teurer im Betrieb.

Je einfacher die Aufgabe für ein Sprachmodell ist, desto schneller kann es reagieren und bessere Ergebnisse können erzielt werden.

Wenn die Eingaben vorverarbeitet und die Informationen so reduzieren werden, dass nur relevante Daten an das LLM übergeben werden, können wesentlich effizientere KI-Anwendungen erstellt werden.

Eine gute Architektur und gutes Engineering sind die wichtigsten Aspekte beim Aufbau ansprechender KI-Anwendungen!

Um eine KI-Anwendung einfach und schnell zu gestalten, müssen Eingabe- und Ausgabedaten intelligent vorverarbeitet werden.

Eine gängige Praxis besteht darin, eine KI-Aufgabe in mehrere Unteraufgaben aufzuteilen, die einfacher zu verarbeiten sind.

Dies lässt sich am besten anhand eines Beispiels erklären. Stellen Sie sich eine Anwendung vor, die eine Beratungssituation im Reisebüro nachahmt.

- Die erste Aufgabe ist, herauszufinden, wohin und wann eine Person reisen möchte.

- Die zweite Aufgabe ist, relevante Aktivitäten für das Ziel und den Zeitraum herauszusuchen.

- Die dritte Aufgabe ist, den Kunden zu beraten, um aus den verfügbaren Aktivitäten die besten auszuwählen.

Die oben genannten Aufgaben können als KI-gestützte Anwendung erstellt werden. Die Aufgaben eins und drei können leicht von einer KI mit den richtigen Anweisungen und Daten ausgeführt werden. Aufgabe zwei würde nicht mittels KI durchgeführt werden, sondern eine Standardsuchanfrage an einen Katalog kann durchgeführt werden.

Dieser Ansatz wird oft als Retrieval Based Augmentation bzw. (RAG) bezeichnet und ist eine gängige Praxis, um KI-Anwendungen die Arbeit mit großen Datensätzen (z. B. einer Tourismusdatenbank) zu ermöglichen.

Datenoptimierung für einen multilingualen KI Chatbot

Einer unserer Kunden ist die „Insel Mainau“, eine berühmte Blumeninsel auf dem Bodensee. Auf der Website wird ein sogenannter Blumenkalender veröffentlicht, in dem nachgelesen werden kann, welche Blumen jeden Monat auf der Insel blühen.

Wenn man die Anzahl der Tokens für die Unterseiten aller 12 Monate berechnet, kommt man auf deutlich über 20.000 Tokens. Diese Zahl entspricht etwa 60.000 Zeichen, was etwa 13.000 Wörtern entspricht. Das ist zu viel Inhalt für reguläre Sprachmodelle und die Verarbeitung dieser Datenmenge wäre zu kostspielig.

Deshalb haben wir den Inhalt reduziert, indem wir ihn gekürzt und alle unnötigen Wörter entfernt haben. Mit diesem Verfahren ist es uns gelungen, die Anzahl der Token für alle 12 Seiten auf unter 4.000 zu bringen.

Originaltext für den Monat März

Was blüht im März auf der Insel Mainau?Im März freuen wir uns auf der Insel Mainau über das Comeback der Krokusse, Narzissen und Kamelien. Doch nicht nur das, denn auch die ersten Schmetterlinge haben bereits ihre Flügel entfaltet und tanzen munter durch die Lüfte.Seit 1973 ist die Orchideenschau im Palmenhaus der traditionelle Auftakt der blühenden Höhepunkte auf der Insel Mainau. Über 3.000 exotische Orchideen-Schönheiten in ihrer erstaunlichen Vielfalt an Formen und Farben werden ausgestellt. Entdecken Sie die lebendigen Farben von Phalaenopsis-, Vanda- und Cattleya-Orchideen sowie botanische Raritäten, die von unseren Gärtnern kunstvoll arrangiert werden....Gekürzter Text für den Monat März

MärzInsel Mainau erblüht vielfältigen Farbenspiel. Krokusse, Narzissen Kamelien bringen Frühling zurück, begleitet ersten flatternden Schmetterlingen. Traditionelle Orchideenschau Palmenhaus zeigt 3.000 exotische Orchideen faszinierenden Formen Farben. Märzenbecher kündigen weißen Blüten Ende Winters, Kamelien rosafarbenen, roten weißen Tönen Ufergarten blühen. ...

Tokens: 297

Zeichen: 927

Wie Sie oben am Beispiel für den Monat März sehen können, wurde der Text stark reduziert. Darüber hinaus ergibt der reduzierte Text für den menschlichen Leser keinen Sinn mehr. Für eine KI spielt dies jedoch keine Rolle, da sie einfach Wörter basierend auf Eingaben anhand ihrer trainierten Muster vorhersagt.

Bei der Übergabe von Daten an ein großes Sprachmodell ist es üblich, alle unnötigen Wörter zu entfernen und sogar unverständlichen Text zu senden, da das Modell diese Daten nicht benötigt, um sinnvolle Antworten zu erzeugen.

Für die Demo haben wir das LLM angewiesen, freundlich und fröhlich zu antworten, um den Ton der Website nachzuahmen. Obwohl die Daten auf Deutsch übermittelt werden, kann die KI sowohl auf Deutsch als auch auf Englisch interagieren.

Deutsch sprechender KI Chatbot

Englisch sprechender KI Chatbot

Testen Sie unsere Anwendungen auf unserer AI-Demo-Website

Auf unserer KI-Demo Webseite können Sie die oben gezeigte Anwendung selbst auszuprobieren. Auf der Demo-Website finden Sie auch weitere ansprechende KI-Anwendungen, die wir erstellt haben. Wir zeigen Ihnen gerne was mit KI heute schon möglich ist.

Sind Sie bereit eigene KI-Anwendungen zu erstellen?

Wenn sie bereit sind eigene KI-Anwendungen zu erstellen, helfen wir Ihnen gerne ihre Projekt zu planen und umzusetzen.

Weitere Highlights

Vorteile von Open-Source-Software für Unternehmen

Wir werden oft gefragt, was Open-Source-Software ist und warum Unternehmen sie gegenüber...

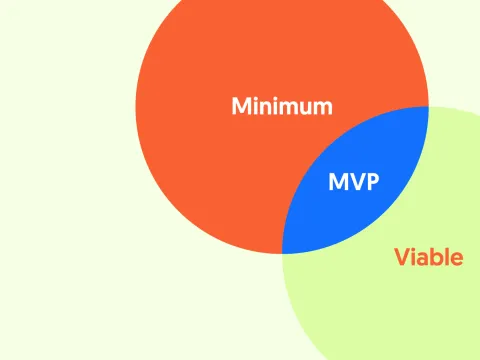

Der MVP-Ansatz für Webprojekte

Bei 1xINTERNET verwenden wir den MVP-Ansatz (Minimum Viable Product), um erfolgreiche Webprojekte zu...